FAQ по видеокартам для майнинга

k0ttee » 11 июл 2017, 09:17

В интернетах навалом как статей так и видосов, которые показывают одно и то же: взять спец-калькулятор, выбрать в нем видяху, ввести цену электричества, получить рассчет профита. Лучше уж так, чем: пойду куплю на какую денег хватит.

Все хотят высиживать в интернетах золотые яйца.

FAQ по видеокартам для майнинга

Сами карты клепают все кому не лень от Асусов до Палитов. Чипы делают всего две компании — нВидэ и Амудэ. Память под это безобразие клепают Самсунги и Хуниксы. И это еще не все

GT или GTX

Буква X может нести разные вкусности, а общее в ней одно — большая ширина шины видеопамяти. Современная видяха это как отдельный комп (с видеочипом и видеопамятью на борту). Точно можно сказать, что GTX за один такт отправит с памяти на чип и обратно от 2 до 4 раз большие данных.

Ti или нет

Буковки Ti (сокращение Titanium) означает более быструю память. Кстати, есть не очевидная штука — дело в том, что саму память на заводах ставят малость разную, отчего одинаковые железки за равную цену (но из разных партий) могут показать разные скорости памяти (сама память ставится Hynix, Samsung, Micron).

GDDR3 или GDDR5

Трешка ставится на дешевые и не особо игровые карточки, в которых слабый видеочип и нет смысла ставить пятерку. Все быстрое игровое и подходящее под майнинг комплектуется пятеркой, есть лишь подводный камень с производителем памяти.

Объем памяти

Если для игрушечек вполне хватит и двух гигов, то для майнинга — чем больше тем перспективнее. Дело в том, что на малом объеме копалка некоторых монет даже не запустится уперевшись в ошибку. Смотрите какой порог входа по объему видеопамяти. С другой стороны — от восьмигиговых нет большого смысла.

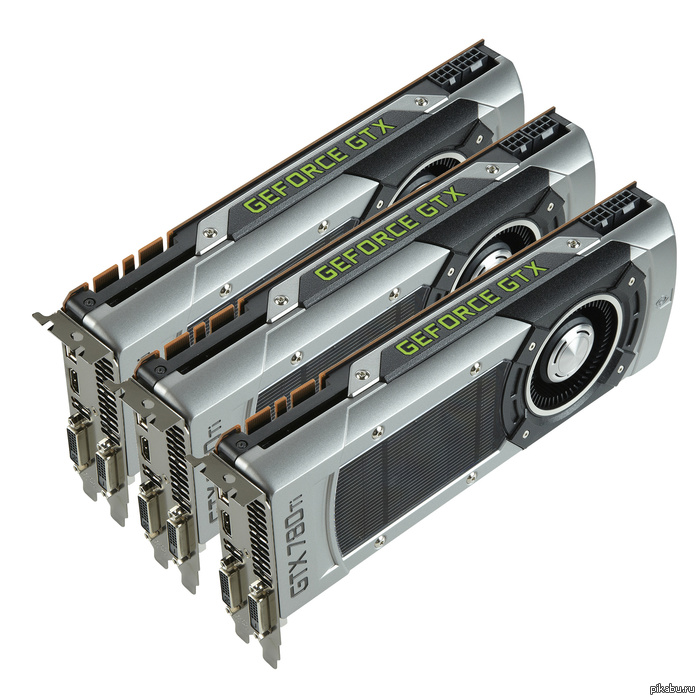

Нужен ли SLI

Сам по себе SLI это как электровоз из пары секций, чтобы тащить графон в высоком разрешении. В майнинге SLI бесполезен, ибо очевидно — ферма это «побольше видях в одну материнку» и все они прекрасно общаются без всяких SLI. Тем не менее, возможно в будущем изобретут алгоритмы.

Все что старее 2010 года уже не найти на прилавках — старое смотреть не будем.

Вот микроархитектуры (их двухбуквенные индексы) и серии выпущенных видях:

Код: Выделить всё Fermi (GF) 400/500

Kepler (GK) 600/700

Maxwell (GM) 800/900

Pascal (GP) 1000

Из этого есть несколько исключений (видяха — архитектура):

Код: Выделить всё 605 Fermi

610 Fermi

620 Fermi

630* Fermi

640* Fermi

645 Fermi

730* Fermi

750 Maxwell

750 Ti Maxwell

640M LE* Fermi

Закономерность тут такая: чем новее поколение видяхи, тем эффективнее соотношение сожранного тока к проделанным вычислениям. Какая видяха сколько чего выкапывает — это вам в спец-калькуляторы.

Особняком стоят серии Quadro и Tesla, которые выпускаются для рендеринга спецэффектов в фильмах, стоят дорого и вообще не обладают выходом на монитор (а-ля как обещанные на осень спец-видяхи для майнинга). Такую видяху потом будет не продать даже мамкиным геймерам.

Пользователи Амудэ, давайте рассказывайте.

Источник

SLI/CrossFire из мощных видеокарт: нужно ли?

Дубликаты не найдены

Не переживай, я плюсанул

Как там живётся при курсе 30 руб? У меня вот в 2018 сталкер 2 анонсировали)

Скорее «оптимально», дальнейший прирост производительности при смене видеокарт заметен меньше. Но это не отменяет собственно прироста. 🙂

Да и оперативная память не так уж нужна, если вы увлекаетесь только играми. Предположим у вас 4 GTX TITAN с 24 гигабайтами памяти на борту… Ну а что? Реалии топовых компьютеров. Назовите игру, которая выжрет 8 гигов оперативы при этом. Я просто хочу увидеть эту игру. =)

16 гигов озу? Ну я хызы даже для i7…

Ну ладно, я вас понял, 500 ватт хватит всем, мощные видеокарты для слабых процев не нужны. Я останусь с мнением, что видеокарта рулит, а проц можно и попозже обновить, если что. И БП лучше иметь с запасом. Хуже не будет, учитывая его цену.

Что спорить то, вот ссылка на тесты из которых видно что карты в паре SLI рвут все топовые одиночки — https://www.techpowerup.com/reviews/NVIDIA/GeForce_GTX_1060/17.html

Может, я не знаю, куда там смотреть, но я так и не нашел в таблицах 1060 SLI…

Не знаю кто о чем, я лично спросил об играх. =) Все во что я поиграл меня не потрясло, мощности одной видяхи хватает. Что даст 2 или 3 не знаю.

Пост по сути об играх. Как-то так вышло…

А еще, замечу, что вы тоже ересь сморозили. Это не каждому коду нужно железо, а каждому железу нужен свой код. Есть сертифицированные технологии, которые поддерживаются разными программами. Я пока не слышал, чтобы Adobe, Autodesk и Sony выпускали свои видеокарты для рендеринга «своих» кодов. А вот поддержка CUDA — это знакомое словосочетание.

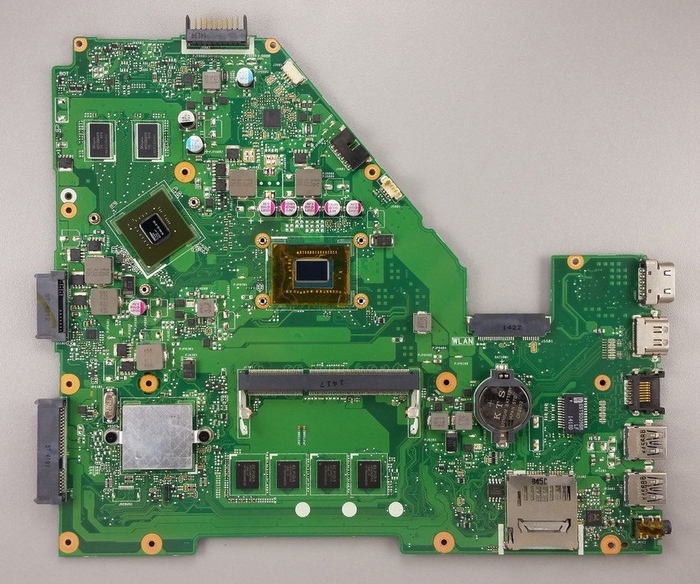

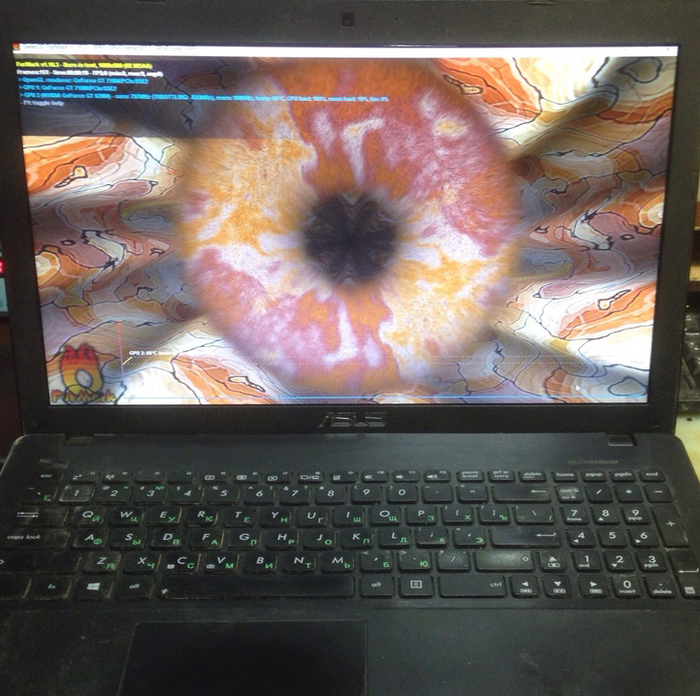

Ноутбук Asus X552C после удара

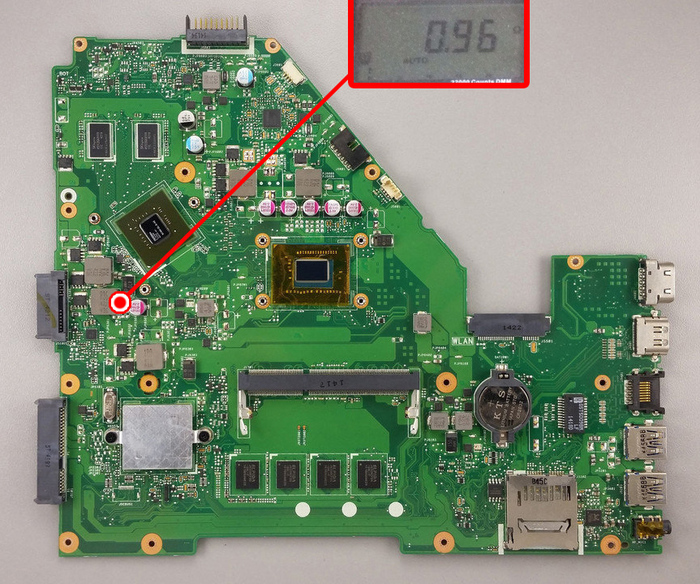

Ноутбук Asus X552C принесли с жалобой на то что не включается после удара по клавиатуре.

Слегка ударили, он выключился и теперь не включается

Разбираю ноутбук и снимаю радиатор с материнской платы

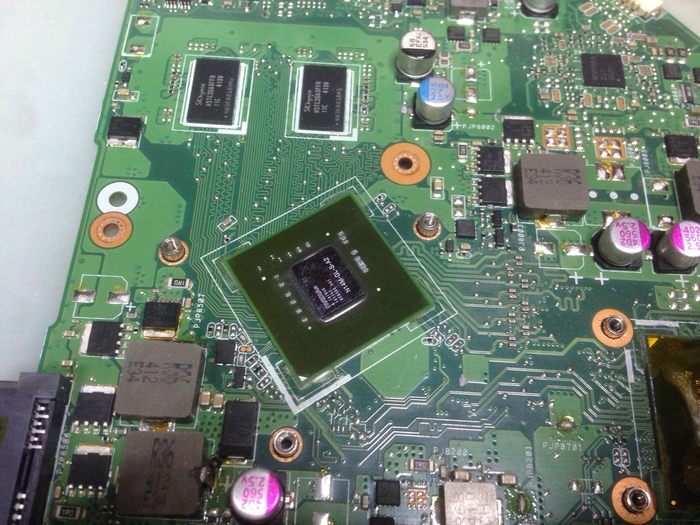

Сразу же обращаю внимание на видеочип

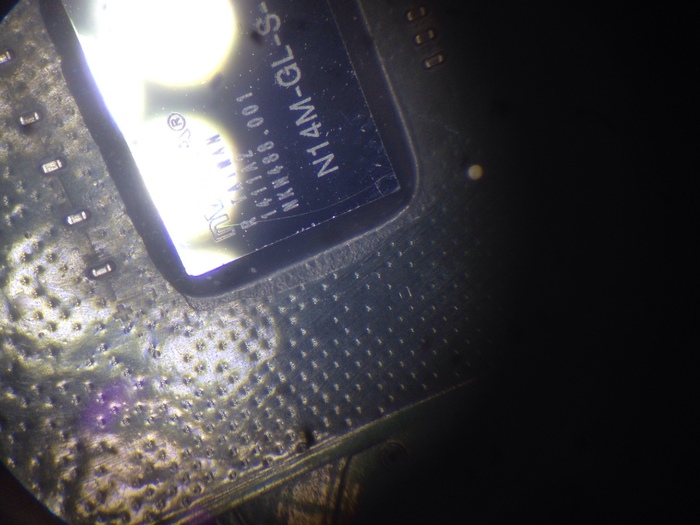

На кристалле большая трещина

Замеряю сопротивление видеоядра. Менее 1 Ом.

Это короткое замыкание, видеочип необходимо менять на новый. Либо можно снять и переделать плату только на встроенную графику.

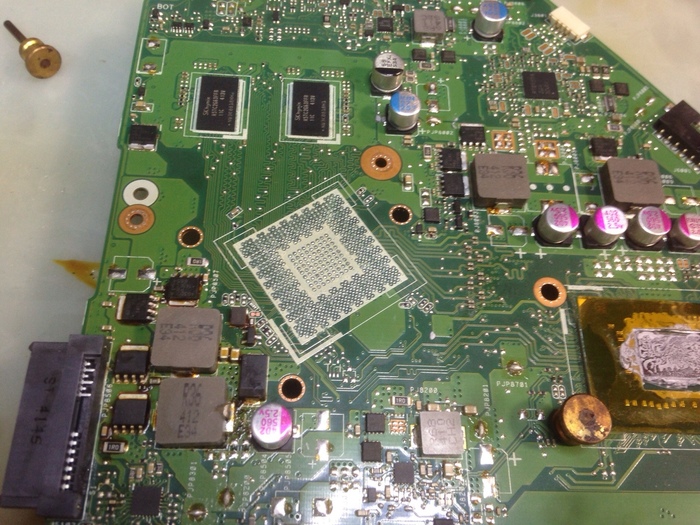

Снимаю микросхему на паяльной станции.

Поскольку стоимость данной микросхемы не высокая, было принято решение поменять графику без переделки платы. Плюс на данной платформе можно поиметь проблемы с куллером после отключения дискретной графики. Прошивка Bios на версию uma может не помочь.

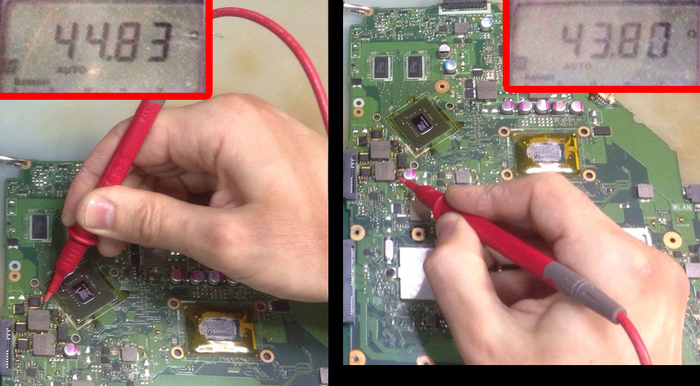

Поэтому запаиваю новый исправный видеочип и проверяю его сопротивление ядра.

Сопротивление в норме. Теперь можно пробовать включать ноутбук.

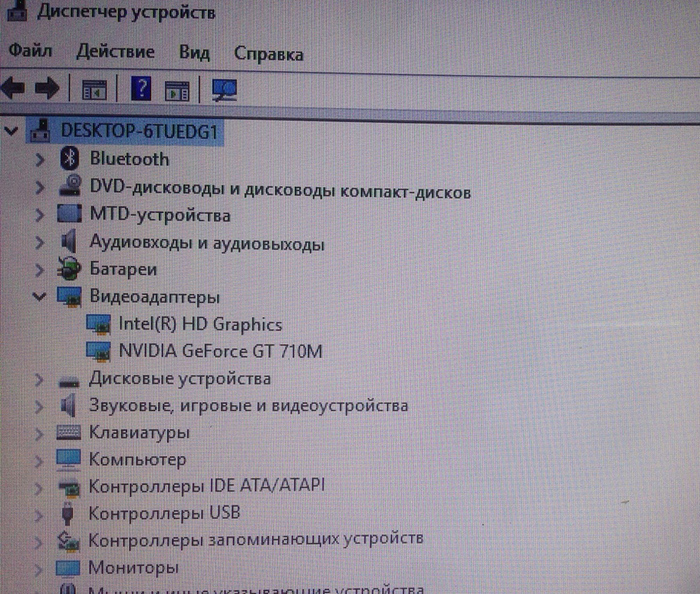

Включается, работает. С видеосистемой всё в порядке

Все тесты под нагрузкой прошли успешно. Ремонт ограничился заменой видеочипа.

Nvidia RTX 20XX: революция в графике или голый маркетинг?

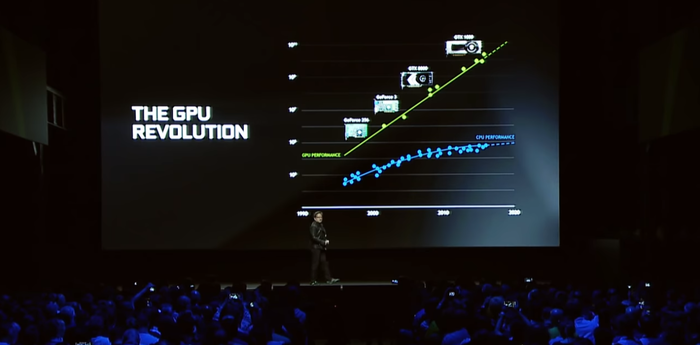

«Революция! Новый виток в развитии компьютерной графики! Бескомпромиссное качество визуализации!» – Глава Nvidia Хуан Жэньсюнь не стеснялся в определениях на презентации нового поколения видеокарт. Конечно, такой уважаемый человек врать не будет, но мы всё же попробуем трезвым взглядом оценить потанцевал новых зелёных карточек.

Для тех, кто всё пропустил

Очень скоро в Кёльне начнётся (возможно, когда вы это читаете, она уже прошла) конференция Gamescom 2018 – это такая «Е3 для бедных». Открывала событие компания Nvidia со своим GeForce Gaming Celebration, от которого никто не ждал ничего, кроме официальной презентации новой линейки видеокарт. Единственный спикер мероприятия Хуан Жэньсюнь не стал выкручивать коту хвост и сразу дал понять, что карточки будут, за что ему досрочно хотелось отреспектовать. Началось всё действительно очень бодро.

Всё слухи и сливы не имели ничего общего с реальностью. Вы будете очень удивлены! – Хуан Жэньсюнь

Хуан, видимо, плохо следил за сливами, ибо вторая их волна в точности описала все презентованные карточки. Ну да ладно. Следующий час с лишним глава Nvidia эмоционально рассказывал о том, чем мы так сильно должны быть удивлены.

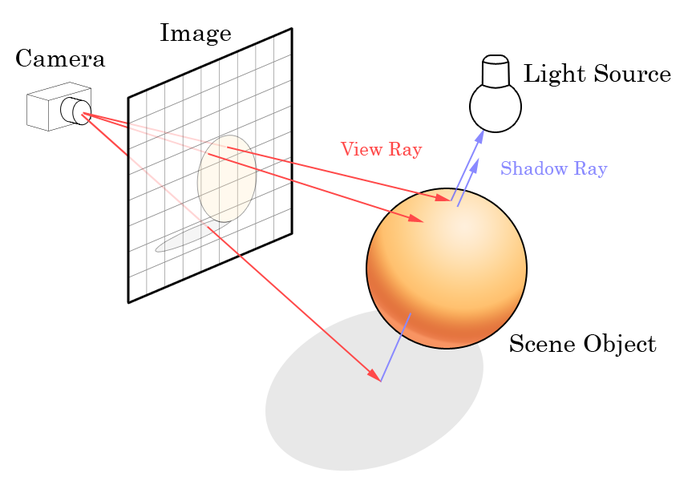

И пришёл Ray tracing

Трассировка лучшей – метод рендеринга 3D-графики, принципиально отличающийся от привычной нам растеризации. Ray tracing подразумевает получение финальной картинки путём построения лучей от камеры наблюдателя к 3D-сцене, которые получают информацию о положении объектов, их тенях и отражениях. При обычной растеризации всё происходило наоборот – готовая сцена проецировалась на плоскость (экран). Объяснение довольно грубое, но если браться описывать тонкости, то пост про видеокарты превратится в научную статью по методам 3D-рендеринга. Кому интересно – тот всегда может просветиться сам, вооружившись гуглом.

Принцип работы Ray tracing

Собственно, про этот самый Ray tracing со всеми его преимуществами и шла речь вплоть до короткой части презентации новых видеокарт. Стоит понимать, что сама Nvidia ничего не изобретала, и о трассировке лучей, как о светлом будущем 3D-графики, говорили ещё в прошлом десятилетии. Частично метод уже использовался в кинематографе и мультипликации, но ни о каком real-time рендеринге речи не шло – всё упёрлось в производительность железа. Заслуга Nvidia заключается как-раз в том, что они наконец разработали техническую основу для внедрения трассировки лучшей в игровую индустрию.

Нас, любителей спускать по десять МРОТов на виртуальные красоты, прежде всего интересуют видимые на экране родного монитора преимущества всех этих сложных технологий. С трассировкой лучей на новый уровень выйдут тени, освещение, отражения и. всё.

Теней теперь больше, а сами они мягче, освещение более комплексное и живое, но главная проблема, которую решает новый рендер – отражения. Эта, казалось бы, ерундовая составляющая 3D-сцены всегда была слабым местом метода растеризации, где любое отражение представлялось просто ещё одной сценой, которую нужно со скрипом отрисовать. Разработчикам приходится выдумывать костыли и всячески ухищряться, дабы обойти технические ограничения. То же самое было и с освещением, когда необходимо расставлять невидимые источники света, чтобы симулировать естественные для реального мира процессы расхождения лучшей света. Ray tracing с удивительным изяществом решает все эти проблемы, внедряя в рендер процессы, программно симулирующие построение изображения в реальности.

Огонь, отражающийся в глазах вояки из Battlefield V. Как мы раньше без этого жили! [sarkasm]

Таким образом новое решение от Nvidia не только улучшит картинку, но и позволит разгрузить разработчиков, частично сняв с них задачи по построению освещения.

Прежде всего, стоит понимать, что любое техническое нововведение в известных рыночных отношениях всегда натыкается на одни и те же грабли. Как пример можно вспомнить многострадальный PhysX, представленный зелёными как мастхэв для современной графики ещё 10 лет назад. Где PhysX теперь? Разработчикам не интересно тратить слишком много ресурсов на технологию, которая будет работать лишь на небольшой доле устройств. Да, Nvidia уверенно опережает AMD на рынке графических решений для ПК, но не стоит забывать, что все консоли (которые приносят львиную долю прибыли ААА проектам) уже традиционно работают на графических процессорах от AMD. Как и в случае с PhysX, зелёным придётся в ручном режиме уговаривать разработчиков, дабы те сделали из своей игры технодемку их замечательной технологии. Кстати, 4A games уже уговорили, и их без того прекрасная Metro Exodus с трассировкой лучей выглядит просто потрясающе. Достаточно ли этого для массового исхода разработчиков на новый рендер? Вряд ли.

Ray tracing в Metro Exodus

Внимательный читатель справедливо заметит, что выше я рассказывал про удобство нового рендера для разработчиков. Да, внедрить Ray tracing – не самая большая проблема, только вот никто не избавит разработчиков от необходимости работать со старым рендером, поскольку трассировку не осиливает даже десятое поколение GeForce, не говоря уже о том, что большинство клиентов самой Nvidia до сих пор сидит на GTX 9XX и GTX6XX. Соответственно, получаем двойной объём работ, который никто не будет на себя брать без адекватных партнёрских соглашений.

Так что там с видеокартами?

Массовые сливы инфы перед презентацией оставили мало места для интриги. Новая серия карточек будет носить индекс вида RTX 20XX. Буква R, вместо G указывает на технологию Ray tracing, а числовой индекс 20XX, вместо ожидаемого ранее 11XX призван продемонстрировать революционность новых видеокарт. Над названием маркетологи поработали, но нас больше интересует результаты деятельности инженеров.

В отрыве от рейтрейсинга новые карты не выглядят чем-то за рамки выходящим. Если говорить о производительности, (что действительно всех интересует), то новая линейка демонстрирует вполне ожидаемые результаты. Сливы тестов показывают прирост производительности от 30% до 50% относительно десятой серии. Кстати, уже официально опубликованные ТТХ новых чипов красноречиво подтверждают слитые результаты тестов.

А вот с ценами всё вышло не так ожидаемо. Стартовая цена RTX 2070 составляет 499$ против 379$ на старте GTX 1070, RTX 2080 продают по 699$ вместо 600$ за GTX 1080, а флагманская RTX 2080ti получила совсем неприличный ценник в тыщу баксов. Само собой, со всеми пошлинами на импорт суммы в рублях получаются ещё более неприятные.

Высокий ценник не помешал первой партии разлететься как горячие пирожки

Конечно, Ray tracing – это никакая не революция, а вполне себе логичный этап эволюции игровой графики. Да, технология нужная и перспективная, но стоило ли делать на ней такой акцент? Маркетологам Nvidia необходимо было выделить продающую особенность новой линейки, при том, что снижения техпроцесса или радикального роста производительности не случилось. Оценят ли всё это потребители – вопрос. Будет ли AMD смиренно наблюдать за происходящим, или попытается умыкнуть из стана зелёных верных клиентов чем-то более соблазнительным – вопрос ещё более интригующий.

Ещё про графические технологии у меня в блоге:

Источник